Sora出现之后,DiT架构在视频生成产品中成为主流技术。这大半年来,Luma AI和Kling突然崛起,成为视频生成领域的黑马,老牌的Runway也推出强大的Gen3模型。AI视频生成在画面表现力、语义理解、清晰度和可控性上有很大进步,并且多家产品在音画同步、笔刷工具等方面进行更新,增强了产品的可控性。

这篇文章将带大家知晓AI视频产品的最新能力、各产品优势并展示其实测效果。

此系列预计含闭源、开源两篇,下面是本文的目录。

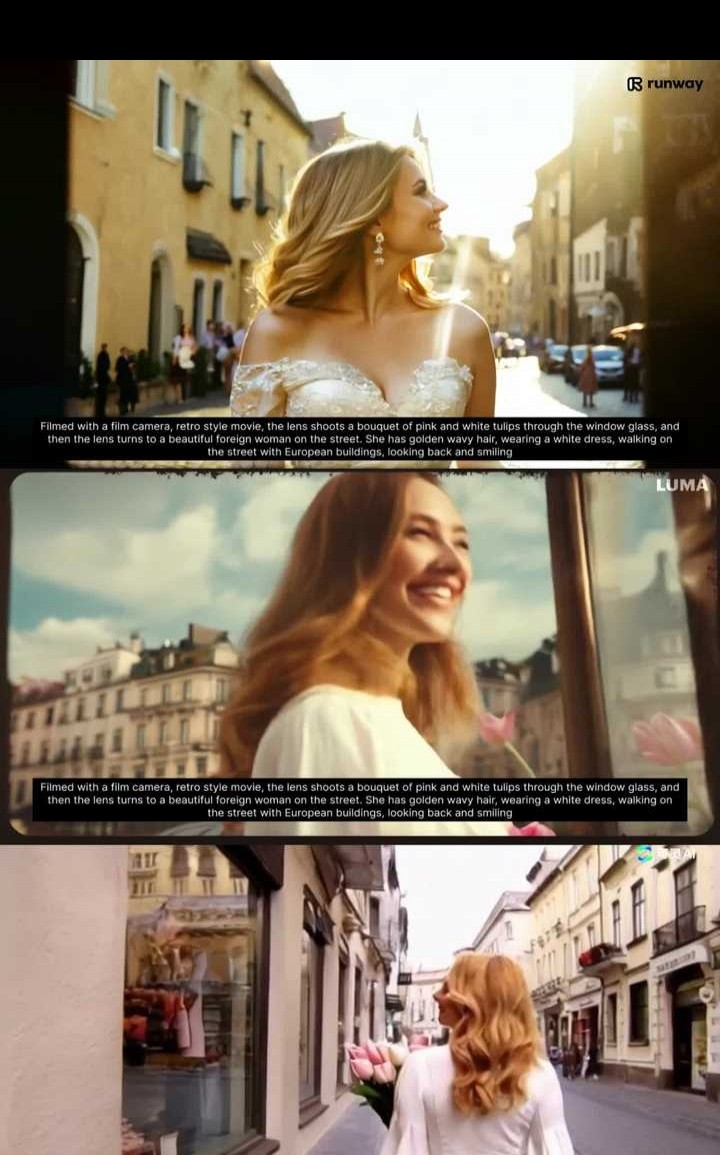

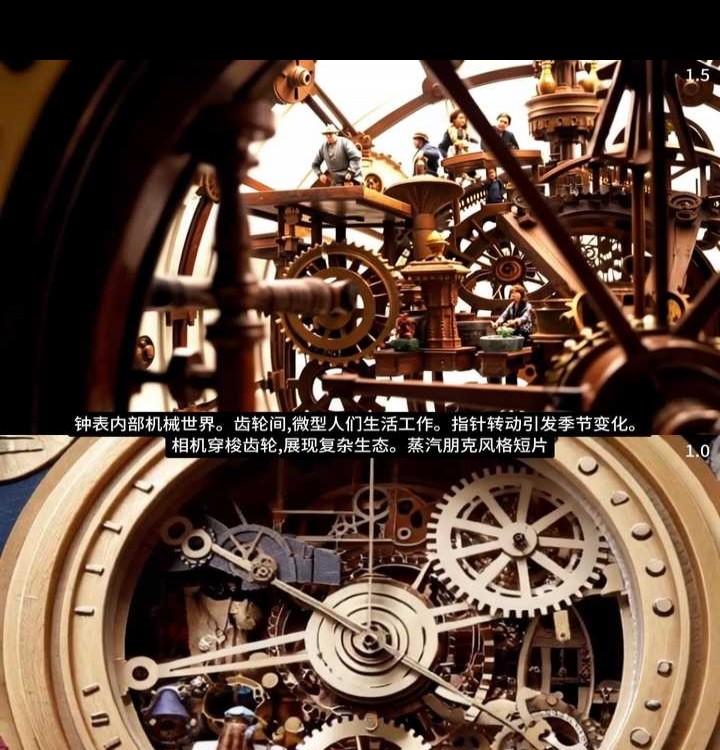

前两个场景于9月初制作完成,当时主要对在AI视频生成方面最热门的Runway(Gen - 3)、Luma AI(Dream Machine1.5)以及可灵1.0展开了测试。

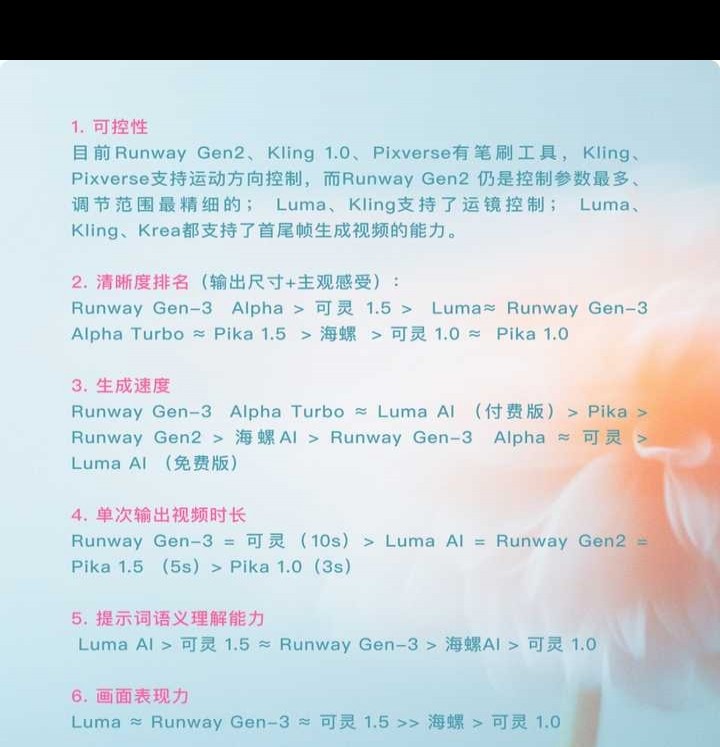

对5个不同场景的表现进行测试,Runway和Luma各有优势,可灵1.0在清晰度、语义理解、画面绘制方面仍需大力提升。

Runway的光影效果缺乏真实感,但整体对各场景的支持度较高。

Kling 1.0整体表现还是很糟,不过其在人物特写和光影方面表现不错。而Luma在人物特写方面比较弱,处理抽象材质运动时却有很好的表现。

9月末测评的案例显示,可灵1.5与Luma、Runway Gen - 3之间的差距在肉眼可见地缩小。

以下都是我多次测试后的主观体验,或许存在测试数据不够、内容维度有限等情况,欢迎大家补充。

物理交互的准确性仍有很大的提升空间。

AI视频尽管动作流畅度有很大提高,但大多仍存在运动合理性问题。实际测试时,视频中有时会有动作突变、不连贯的情况,平面图像生视频时这一问题更显著。

现阶段视频生成时长较短,这与之有很大关系。若提示词、首尾帧要求模型在短时间内处理更大幅度运动,该现象会更显著。

训练数据的多样性仍有待持续提高。

在我做的测试里,能发现类似场景且能力相近的产品,表现差别很大。就像下面这个案例,我在txt2vid中测试了一个关于艺术家在墙上喷绘的案例,Runway的表现非常好,可Kling 1.5还是没什么亮点。

工作所需,我会更留意平面风格图片生成的视频效果。综合来看,由于缺乏训练数据、画面深度信息难识别等原因,除官方Demo外,我真实测试发现,目前所有产品平面方向生成效果都不太理想。

一般我会先用提示词来辅助img2vid,文生图的时候也尽量在图里添加些可运动的装饰元素,像花、树叶、光斑之类的。要是生成效果不好,我就会改用Runway Gen - 2笔刷工具细致调整,防止出现大的问题。有时候二次元人物形象会被处理成真人,这很恐怖谷效应。

再如输入一张卡通狗图片,模型不顾提示词内容,自动生成带有狗狗叫刻板印象的画面。

大幅运动导致的模糊感至今仍未得到解决。

4. 可控性方面依旧存在不足。

在实际生产中,仅靠提示词难以精细描述需求,我们需要更多地掌控AI以实现目标效果。各公司在笔刷工具和运镜控制的支持上存在细微差异,仍有提升空间。

主体物在画面占比小的话,AI易产出镜头位移效果,要达目标效果需增加抽卡次数,因此最好选主体物占比大的图片。

生成视频时,描述词应是画面中存在且容易识别的内容。不然模型会生成新事物,使内容与画面不匹配,造成画面突变。

制作首尾帧视频时,要让画面有相近或相同元素,且保持一定相似比例,如此5秒过渡动画才能过渡得完整又丝滑。

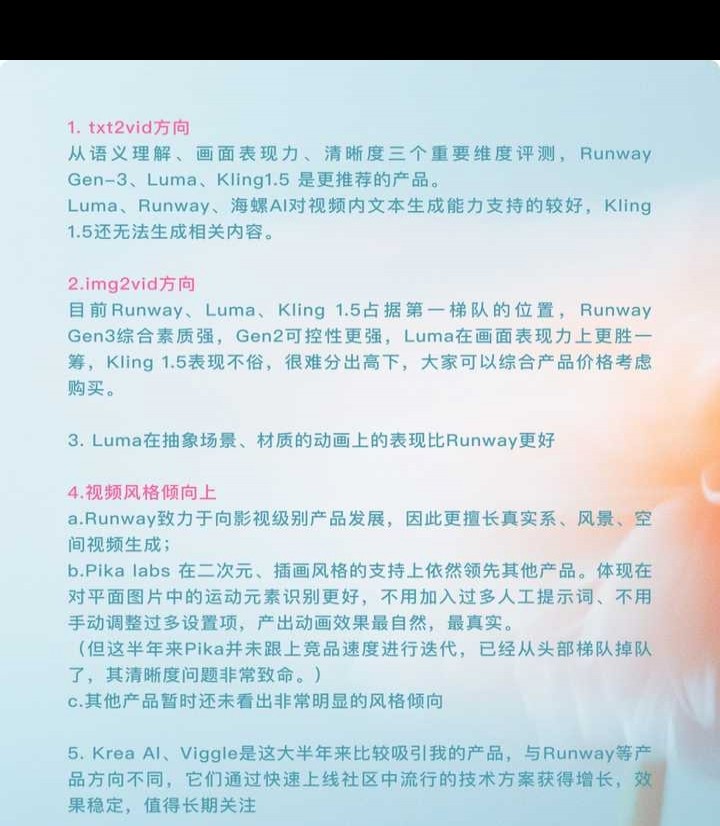

Luma AI本是一家3D生成公司,之前其官方推特一直在发3D模型相关资讯。然而到了6月,它突然推出AI视频生成产品Dream Machine。当时,Runway、Pika还未推出新模型,Sora又遥不可及,Luma AI就这么横空出世了。

在接受海外独角兽采访时,Luma首席科学家称,团队实现4D生成主要考虑两种方案。一是由图像生成3D,再把3D动画转换为4D;二是直接生成视频内容,然后转化为4D。Luma觉得后者更具潜力,还能在一定程度上规避3D数据集不足的问题,这便是Dream Machine诞生的缘由。

4D是3D加时间,即三维空间里随时间改变的对象或环境。

Luma在生成视频时会关注一致性、深度信息(如物体和镜头距离、物体间远近)、光学(光在不同介质中的反射折射变化)以及动态物理现象。

6月我用1.0模型做测试,img2vid能力很强。大幅运动时瑕疵少,原图还原度佳,而且视频里每一段都是一次性输出的。

体验地址:https://lumalabs.ai

Dream Machine当前功能较为单一,仅具备txt2vid文生视频和img2vid图生视频这两种能力。除相机运动外,还支持延长4秒、循环动画、首尾帧动画能力。

产品发布不久便公布后续规划:会支持视频场景修改、尺寸设置和调色等功能。

8月底新推出的Dream Machine 1.5提升了对提示词的理解能力与视频生成能力。让我诧异的是,Luma在视频内文字的表现上也极为出色,这一效果是除Runway Gen3、海螺AI之外的产品目前做不到的。

前段时间我测评各产品的最新模型,发觉Pika labs效果虽好却太模糊,Runway老是生成怪异的运动画面……这些产品的实际表现和宣传片似乎相差甚远。

这恰恰是Luma AI此次更新最令人惊艳之处,官网展示的视频案例真实可靠。它的img2vid生成效果在诸多方面大幅领先Pika labs、Runway等产品,是当前能够公开体验的AI视频生成领域的佼佼者之一,具体体现于以下方面:

生成时长达5秒,每秒24帧,画面十分丝滑。

2.运动幅度更大,可使相机多角度位移。

3.提示词可支持增加相机、无人机控制的视角变动。

4.运动时一致性保持得较好,有时图片像变成了3D模型。

5. 分辨率高,能有效改善因运动幅度大而产生的模糊感,这是pika labs一直让我困扰的问题。

9月初,Luma上线了类似Animatediff V2模型的相机运动功能。我很喜爱这种由提示词触发选项的交互方式,它不像增加操作按钮那样。其视频节奏轻松又可爱,值得观看。

Luma和Kling现在都能通过输入起始与结束关键帧来生成视频,用户还能添加Prompt提示内容的变化,从而控制视角与主体物的运动。首尾帧功能衍生出不少新奇玩法,像:

多张首尾帧相连能接成更长视频,多场景切换有奇幻感,很多意想不到之事被联系起来。

2.借助季节、时间、环境和主体物生长变化,能呈现延时拍摄的效果。

3.达成意想不到的衔接效果。

像从微观到宏观转换、场景间转换之类的。

4.制作转场动画。

虽说还达不到Keynote神奇移动的效果,目前用AI来制作UI、PPT动画确实有点屈才了。不过可以发现,AI在处理首尾帧动画时,能让前后两帧的相同元素有合理且良好的过渡效果,而像只在尾帧出现的文字元素Design Odyssey,其动画更多是由AI自行发挥的。

若日后有产品可增加垂类数据训练,设计师制作UI、PPT动画或许会更轻松。

目前,Luma已经开放Dream Machine API以供开发者调用。

Runway是最先推出模型的AI视频产品,至今仍居王者之位。虽有Luma等新产品追赶,但这半年来,Runway在模型与产品功能方面持续快速迭代。

Runway的产品定位更倾向于影视与艺术表达。我测试发现,它在生成真实系、风景和空间视频方面表现更佳;对二次元场景支持不好(这也是此类软件的常见问题),经常会把二次元人物生成真人动画。

特别的是,Runway支持绿幕场景生成与视频绿幕抠像等功能,这对影视制作和后期进行AIVideo二次处理极为方便。

Runway目前支持的场景和视频案例可在此查看:https://runwayml.com/product/use-cases。

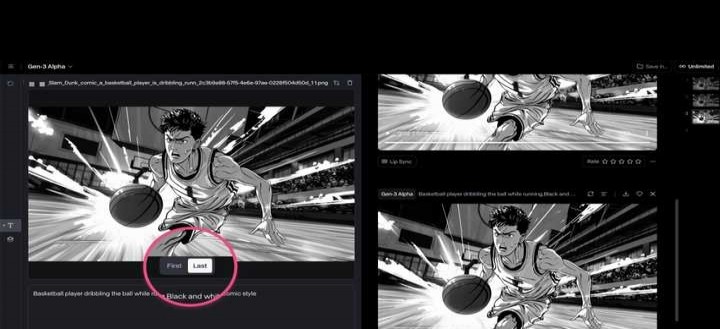

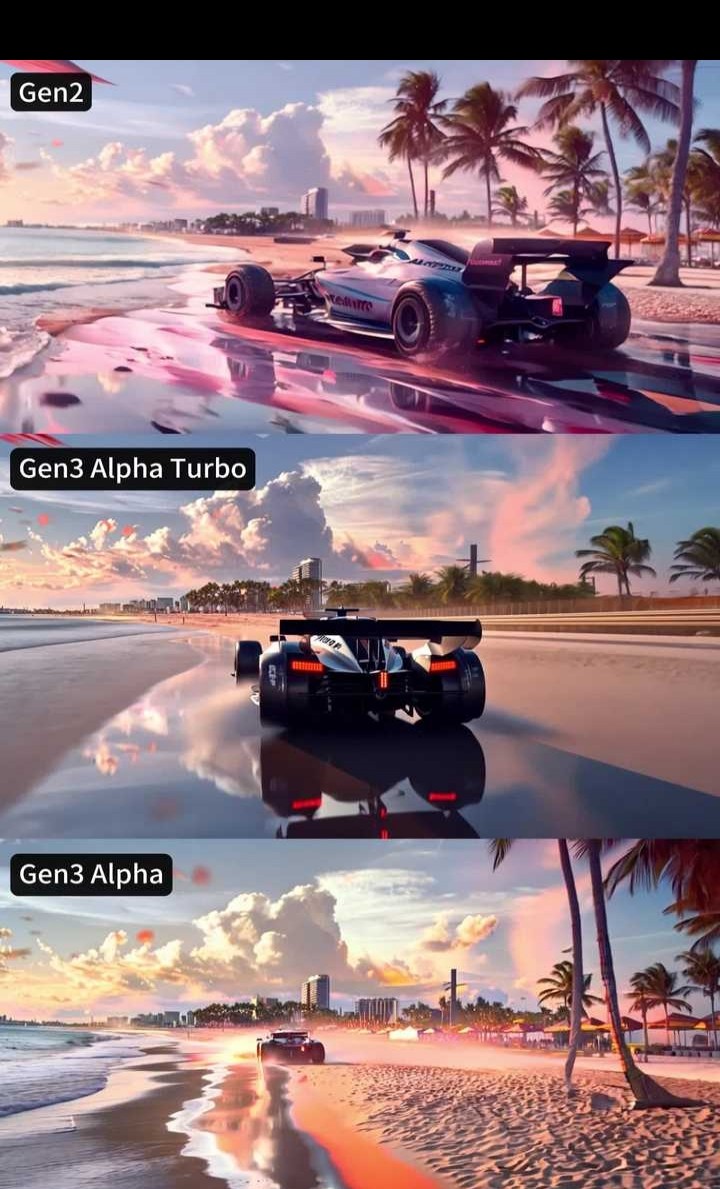

7月更新的Gen - 3,有Alpha Turbo(速度更快)与Alpha(表现力更强)两种模式。它对极为复杂的提示词描述理解能力增强了,图像运动元素识别能力也提高了,还能实现充满想象力的过渡以及场景元素的精确关键帧。

另外,可设置图片为动画首帧或尾帧,不过Gen3现在尚不支持笔刷等高级调节功能。

将图片作为尾帧输入时,更利于无中生有地生成元素,如下述水墨画就是很好的例子。

Runway单次生成视频最长可达10秒,且能延长至40秒,这是目前AI视频产品输出的最长时长。

此外,Gen - 3 Alpha Turbo已支持竖屏尺寸视频生成,在视频到视频(风格转绘)能力上加大发力,还宣称即将推出更多控制能力。

上半年,Runway的Gen2模型具备较多细节控制能力,还支持精细数值调节,在当前AI视频生成产品里可控性位居首位。

多笔刷对局部运动进行控制。

最多支持5个笔刷控制,涵盖物体运动方向与运动曲线调节。若调高Ambient,笔刷绘制区域的物体运动与周边环境联系增多,运动幅度也会加大。

支持水平或垂直平移、翻转,以及镜头缩放或旋转。

最终生成的效果进行对比:

Gen3在清晰度方面提升明显,画面更富想象力,仅凭提示词就能有很好效果,无需复杂控制。而Gen2则更适合需要精准控制运动范围的场景。

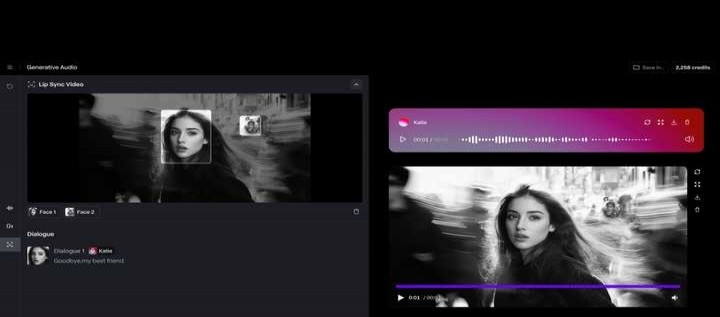

在已生成的视频下方能够选择Lip Sync,把对口型与img2vid能力相结合,从而使嘴形和视频其他部分都呈现自然的动态效果。

不管是工具栏里日益丰富的音频、视频处理能力,还是Runway Watch栏目中的出色合作案例,都表明Runway始终朝着影视制作方向稳步发展。要是日后能够打通AI生成与视频剪辑能力,Runway将会在影视制作中发挥极为关键的作用,成为视频领域不可或缺的重要工具。

今年6月,被视作国产之光的Kling因让老照片动起来让照片中的人拥抱等热门功能在互联网上大火。它高质量的视频效果、极低的价格以及良心的免费额度,使其大获好感。到了9月,Kling更新1.5模型能力,视频的画面表现力、对提示词的理解能力、画面清晰度都有大幅提升,跻身视频生成产品第一梯队。

目前,免费用户每天可免费获取66灵感值,1.0模型生成一次视频要10灵感值,1.5模型需35灵感值。付费用户能够拥有1.5模型,还可去水印、生成高清晰度视频、延长视频、运用大师运镜、增强AI生图画质。

快影:一款移动端APP。

网页版可访问:https://klingai.kuaishou.com/

除传统的txt2vid、img2vid外,Kling还具备首尾帧控制、视频延长和对口型能力。

txt2vid模式支持运镜控制。普通用户能使用水平/垂直运镜、推近/拉远、垂直/水平摇镜,还有四种有趣的大师运镜,不过仅付费用户可用。

9月中旬,Kling为1.0模型添加了运动笔刷控制功能。

在我进行的评测里,可灵的优点是运动幅度大,能带来惊喜效果(这一点和Luma相似,在img2vid方面甚至比Runway更好)。不过,在视频清晰度、语义理解和画面表现力上,可灵1.0远不如Runway和Luma的最新模型。可灵1.5进步显著,达到了我所认为的付费产品应有的水平。

9月24日,字节推出了PixelDance和Seaweed这两款视频AI模型。从官方演示来看,这两款模型在长提示词、人物连续动作转换、多镜头组合以及人物一致性方面表现出色,有望成为国内AI领域的头部核心竞争者。目前该产品仍处于开放内测申请阶段。

网页版可通过https://jimeng.jianying.com/ai - tool/home/进行访问。

内测申请地址:https://bit.ly/jimengai。

MiniMax推出的产品,出场视频演示令人惊艳。简单测试可知,其画面清晰度、表现力等方面均优于可灵1.0。在近期Vbench排行榜上,海螺还取得了16个维度综合评分第一名的成绩。

当前仅可使用txt2vid方案。网页版可访问:https://hailuoai.com/video。

阿里云旗下产品上半年有不少现象级案例广受关注,像奶牛猫跳洗澡舞、全民跳科目三(通义千问APP可体验)。9月其视频生成产品开放预约,生成一次视频要10分钟,测试发现生成效果不太理想。

网页版可访问:https://tongyi.aliyun.com/

移动端可在通义APP进行下载。

因篇幅所限,下篇点此查看:

解析大模型应用的最新方向:GPTs、中间层、Chatbot虚拟社交、AI Agent。

AI视频生成(中):20个产品推荐与实践教学。

AI视频生成(下):20个产品推荐与实践教学

搞懂语言大模型(番外篇):精选40多个应用案例。

产品的发展趋向。

产品趋势02期(上)|Arc号称最强,挑战Chrome,它到底牛在哪?

产品趋势02期(下):Arc设计细节、槽点及后续规划大盘点

商业领域的创业。

Open AI创始人的斯坦福创业课,看完后我学到了什么?