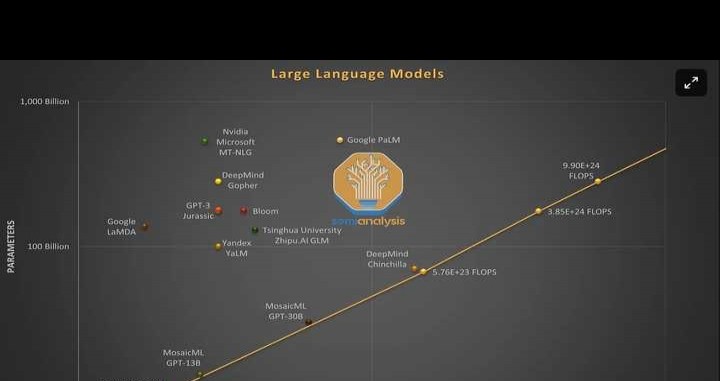

GPT-4共有120层,参数达1.8万亿,相比之下,GPT-3仅约1750亿参数。

GPT-4的规模超过GPT-3的十倍以上。

为控制成本,OpenAI采用MoE模型构建。这种方式能在降低成本的同时保持性能。

具体来说,GPT-4包含16个专家模型,每个MLP专家约1110亿参数,前向传播时选用其中两个专家模型。

此外,模型约有550亿参数用于注意力机制共享。

每次前向推理生成一个token时,GPT-4仅需约2800亿参数和560TFLOPs的计算量。

这与多数纯密集模型每次前向传播需约1.8万亿参数、3700TFLOPs形成鲜明对比。

GPT-4由OpenAI利用13万亿个token训练而成。

这个数据集不仅包含13万亿个token,还因缺乏高质量token,涵盖了多个epoch。

Scale AI和数据集中,包含数百万条指令微调数据,用于模型优化。

批处理大小在集群中会逐步增加,通常在几天内完成,最终OpenAI将其设定为6000万。

当然,这只是每个750万token的专家模型的规模,毕竟并非所有专家模型都会处理全部token。

训练GPT-4约需2.15e25浮点运算,使用约25000块A100GPU,耗时90至100天,设备利用率为32%到36%之间。

利用率极低, partly 因故障过多,导致需从检查点重新训练,如前述气泡成本问题。

若该集群实际由多个较小集群组成,且这些小集群之间的网络连接较弱,则集群内不同部分的非阻塞连接带宽为800G/1.6T,而部分之间互连的带宽仅为200G/400G。

假设OpenAI的云计算成本约为每A100小时1美元,在此条件下,训练成本大约需要6300万美元。

这尚未涵盖所有实验、失败训练及其他成本,例如数据收集、强化学习与人力投入等。

若综合上述因素,实际成本将高出许多。

此外,前提是别人能买到芯片、网络、数据中心等资源,承担资本支出搭建系统,并将其租给OpenAI使用。

如今,在每H100小时2美元的情况下,预训练可借助约8,192个H100 GPU,在55天内完成,成本约为2150万美元。

ChatGPT已更新至4.0版本,性能更强大。

ChatGPT已更新至4.0版本,赶快升级体验吧!我已使用数月,稳定可靠,无任何问题!