问题虽提得不太精准,不过要是将错就错去讨论,我认为最关键的在于:

其他因素如人、钱、算力虽重要,但并非其他公司无法做到。下面展开论述。

首先,AGI相当玄奥,既无明确的定义,也无评判标准。所以没人能确定当下的路径是否正确通往AGI。说不定真到AGI实现之时再回首,会发现OpenAI曾将众人引入歧途,甚至AI可能还会在某个阶段停滞一段时间。

如今,人们对于AGI的普遍认知为人类水平的智能。

OpenAI章程里对AGI的定义为:高度自治的系统,该系统在多数具有经济价值的工作中表现优于人类。

马库斯对通用人工智能(AGI)的定义为:任何一种(可能有很多种)灵活且通用的智能,其智谋和可靠性能够与人类智能相当,甚至超越人类智能。

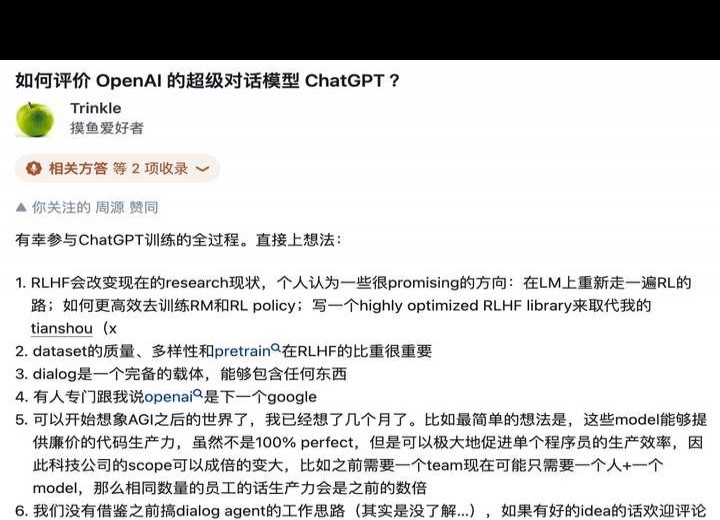

如此看来,OpenAI谈不上跑通了所有AGI技术栈。不过,OpenAI看起来确实强得离谱,能碾压Google,力挫Meta,每次都能拿出真正最先进(SOTA)且长时间占据榜首的产品。

回到当初大家对GPT - 4和Q*的讨论,不管正确与否,大家最后普遍得出的结论是:OpenAI并没有什么独特的绝招,和大家走的路并无二致。

但OpenAI的成功之处在于坚持走(从目前或结果来看)正确的道路——大一统的Transformer。Ilya也不止一次在多种场合表达过自己对Transformer的看法。

再来看,哪怕是最新推出的Sora,其基础仍然是Transformer,这一点并没有改变。并且他们也直接表明了,就是采用与训练大型语言模型(LLM)相同的方式来训练视频模型,也就是把视频压缩成patch(等同于LLM中的token)后交给Transformer,再利用Diffusion进行生成。

方法论简单得被人调侃,只看报告的话,Sora在顶会会被拒稿。

这无法解释OpenAI的成功。毕竟Transformer于2017年出自谷歌且被广泛使用,那为何别人没做出类似成果?

答案或许就是Scale Law,给予更多数据、更大算力,更大的模型必然会更强大。

有一种观点认为,如同GPT - 4那般,Sora的成功也可以归结为力大砖飞这四个字。要是非得比较Transformer和Scale law的重要性,我会认为Transformer是OpenAI的路线根基,而Scale law近乎一种信念,一种只要大胆增加数据量就能看到涌现现象的信念。

当然,投入得讲究投资回报率(ROI)。即便OpenAI的研发环境比大公司宽松,大概也不会毫无节制地烧钱。Scale law背后另一个隐含的理论依据或许是摩尔定律,或者再进一步说是Sam Altman提出的万物摩尔定律。

其实,「缩放定律」的根基是「摩尔定律」,也就是算力的加倍增长。人类的智力大体上是固定的(除非有别的开发途径),而机器的智能由算法、数据和算力决定。按照摩尔定律,当前算力还在发展。假设人类智力不变,机器智能(在遇到瓶颈前)持续进步甚至加倍提升,那最终会达到人类的智能水平。即便未来传统计算机接近摩尔定律的极限,也能够凭借量子计算的发展来继续推动AI的进步。

因此,算力必然会持续增大且不断贬值。当前算力或许存在短缺情况,但闲置算力不仅在当下是种浪费,从长远看还会不断贬值。所以必须充分利用每一点算力,从而抢占人工智能发展的先机。

不细说了,还是引用伊利亚(Ilya)的话吧。

有人引用了Jim Fan的看法,实际上他后来又更新了一段话。

我大概是这么理解的。

最后还有一点比较虚的方面,那就是OpenAI的愿景以及领导者的洞察力。团队的愿景与讲故事的能力,能够吸引人才、投资,还能塑造文化。

领袖的洞察力至关重要。像Ilya对Transformer、强化学习,Sam对投资、算力、产品,Greg对工程和AI infra等方面的洞察力。所谓洞察力,就是在众人面对未知与迷茫时,能从模糊方向中看到希望,果断决策,赋予大家探索未知的勇气。

当下的AI仍像是在炼丹抽卡,像GPT - 4、Sora这类产品,在成功之前,持续坚定地投入人力、财力和算力很关键,OpenAI做到了这点,而其他公司却没有。

以上仅为个人观点。就像之前所说的,或许在几年、十年或者几十年之后,OpenAI重新将其模型开源,而如今的亲历者写下回顾历史的回忆录时,我们才会知晓AGI的火花究竟是怎样产生的,才会明白当下之事是多么了不起。

以上。